Mit Machine Learning

15.12.2019, 11:15 Uhr

Neuer Schub für Open Data

Der Einsatz von Machine Learning in Kombination mit Open Data ebnet den Weg für zahlreiche Anwendungen. Doch die Nutzung der smarten Algorithmen ist nicht ganz ohne. Neue Konzepte zeigen, wie der Erfolg gelingt.

Auf der Website opendata.swiss können Anwender über 7000 öffentliche Datensätze, sogenannte Open Data, für Projekte nutzen. Die Informationen stammen von Behörden und Ämtern, etwa vom Bundesamt für Statistik oder dem Bundesamt für Gesundheit. Überdies bieten auch immer mehr Städte und Gemeinden ihre Daten für IT-Projekte an – offen und gratis. Daraus entstehen Anwendungen wie das Spital-Portal welches-spital.ch für Patienten auf der Suche nach dem für sie besten Krankenhaus oder Apps, die in Echtzeit freie Parkplätze anzeigen.

Open Data gewinnt an Bedeutung

Neben dem akademischen Umfeld setzt sich insbesondere auch im staatlichen Bereich immer mehr die Überzeugung durch, dass die öffentliche Hand ihre Daten Bürgerinnen und Bürgern sowie Akteuren aus der Wirtschaft zur Verfügung stellen sollte. Natürlich nur, soweit das sinnvoll ist und nicht durch andere Anforderungen wie das Urheberrecht und den Datenschutz verhindert werden.

Angetrieben wird der aktuelle Trend neben Akteuren wie opendata.swiss oder Events wie das Opendata-Forum auch durch die Schweizerische Bundesverwaltung, die aktiv Daten aufbereitet und anbietet: Der Linked Data Service (LINDAS) wurde 2015 vom Seco lanciert und wird seit 2017 vom Schweizerischen Bundesarchiv geführt. Es ist geplant, den Service auszubauen. Durch diesen können Anwender auf Daten verschiedener Eigentümer zugreifen, verarbeiten und dann dem allgemeinen Publikum, den Datenkonsumenten, zur Verfügung stellen.

Fünf Sterne für öffentliche Daten

Das Konzept von Open Data entstand 1957 im Rahmen des geophysikalischen Jahrs. Ziel war es, den Austausch und die Nutzung wissenschaftlicher Daten zu fördern. Einen entscheidenden Meilenstein setzte Tim Berners-Lee 2006 durch einen Vorschlag von Kriterien, die eine möglichst schrankenfreie Nutzung von Open Data sicherstellen sollten. Er verfeinerte die Klassifizierung zu seinem Fünf-Sterne-Entwicklungsschema für Open Data. Hierbei werden mit jedem zusätzlichen Stern die Kriterien der tieferen Level ergänzt:

★ Die Daten sind im Web verfügbar.

★ ★ Die Daten liegen in einem maschinenlesbaren, strukturierten Format vor.

★ ★ ★ Die Daten sind in einem nicht proprietären Format verfügbar.

★ ★ ★ ★ Es werden offene Standards des W3C verwendet wie RDF und SPARQL.

★ ★ ★ ★ ★ Die Daten werden mit anderen Linked Open Data verknüpft.

★ ★ Die Daten liegen in einem maschinenlesbaren, strukturierten Format vor.

★ ★ ★ Die Daten sind in einem nicht proprietären Format verfügbar.

★ ★ ★ ★ Es werden offene Standards des W3C verwendet wie RDF und SPARQL.

★ ★ ★ ★ ★ Die Daten werden mit anderen Linked Open Data verknüpft.

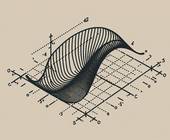

Sind diese fünf Kriterien erfüllt, spricht man von Linked Open Data. Das vierte Kriterium bedarf einiger Erläuterungen: Resource Definition Framework (RDF) erlaubt es, Metadaten in einer für Menschen und Maschinen lesbaren Form zu erstellen sowie semantische Technologien zu benutzen. Mit Ontologien können die Strukturen der Daten definiert werden. RDF und Ontologien erlauben Datenstrukturen, die komplexer sind als einfache Tabellen, nämlich sogenannte Wissensgraphen. Ebenso ermöglichen es Ontologien, Regeln zu definieren, mit denen aus expliziten Daten auch Fakten abgeleitet werden können.

Ein Beispiel: Wenn bei Personen eine Eltern-Kind-Beziehung definiert ist, kann mit einer Ontologie auch eine Grosseltern-Enkel-Beziehung bestimmt werden; ob Person A Enkel von Person B ist, kann dann abgeleitet werden, ohne dass dies explizit in den Daten gespeichert werden muss. SPARQL ist wiederum eine Abfragesprache für diese Datenstrukturen. Diese Ontologien bildeten auch das Rückgrat der Vision des semantischen Webs.

Autor(in)

Computerworld

Redaktion