Mit Analyse-Tools relevanten Daten auf der Spur

Von KI bis zu Edge Analytics

Zu den Entwicklungen, die den Bereich Datenanalyse und Business Intelligence in den kommenden Jahren massgeblich prägen werden, zählt der Einsatz von maschinellem Lernen (ML) und Künstlicher Intelligenz (KI).

Nahezu alle Anbieter von BI- und Analytics-Software haben ihre Produkte um solche Funktionen ergänzt oder haben dies in absehbarere Zeit vor. Ein wichtiges Kriterium ist dabei, den Nutzern den Einstieg in Künstliche Intelligenz und Machine Learning so einfach wie möglich zu machen.

„Die SAP Leonardo Machine Learning Foundation bietet Kunden, Partnern und Entwicklern digitale Intelligenz – und zwar unabhängig davon, ob diese sich erstmals mit diesem Thema beschäftigen oder bereits über eigene Data-Science-Teams verfügen“, erklärt beispielsweise Markus Noga, Leiter des Bereichs Machine Learning bei SAP. Der deutsche Software-Konzern hat Ende 2017 seine Machine-Learning-Plattform um Services erweitert, die unter anderem mehrdimensionale Zeitreihenanalysen ermöglichen. Damit können Anwender unter anderem den optimalen Preis für ein Produkt ermitteln.

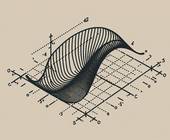

„Bei Analytics- und vor allem Cloud-Spezialisten gibt es derzeit ein heisses Eisen, nämlich die Vertiefung des maschinellen Lernens über Deep-Learning-Systeme beziehungsweise neuronale Netzwerke, die mittels Plattformen und Schnittstellen angesteuert und verknüpft werden können“, bestätigt auch Heiko Henkes, Manager Advisor bei ISG Research Deutschland.

Deep Learning ist eine Technik, die es Systemen gewissermassen erlaubt, eigenständig zu lernen und dadurch Muster und Cluster in grossen Datenbeständen zu identifizieren. Techniken wie Deep Learning werden auch deshalb an Bedeutung gewinnen, weil durch das Internet der Dinge die Datenbestände sprunghaft anwachsen.

Je mehr Daten erfasst, aufbereitet und ausgewertet werden sollen, desto mehr Rechenleistung ist jedoch erforderlich. Um Engpässe in den Rechenzentren für die Cloud-Dienste zu vermeiden und die Datenleitungen zu entlasten, zeichnet sich im Bereich Analytics eine Dezentralisierung ab: Systeme am Rand eines Unternehmensnetzes führen eine erste Bearbeitung von Daten durch. Dies ist speziell in IoT-Umgebungen wichtig, in denen Daten in Echtzeit verarbeitet werden müssen. Dazu zählen zum Beispiel Produktionsumgebungen. So kann etwa ein Laufband bei Problemen nicht einfach stillstehen, bis die IoT-Sensoren Rückmeldung aus dem Rechenzentrum in der Cloud erhalten. Hier ist eine möglichst rasche Verarbeitung der Daten unerlässlich.

Für solche oder ähnliche kritische Einsatzzwecke stehen spezielle Analyse-Lösungen bereit. Führende Anbieter in diesem Bereich sind derzeit Microsoft mit Azure Stream, IBM mit Watson sowie Cisco Connected Steaming Analytics. Auch Intels Analytics Toolkit und Oracle mit Oracle Edge Analytics sind in diesem Marktsegment aktiv.

Solche Datenanalyse-Plattformen werden ebenfalls in der Regel als Cloud-Service angeboten. Damit haben auch kleinere Unternehmen die Chance, in diesem Umfeld mitzuspielen. Speziell für Deutschland mit seinen vielen Tausend kleineren Mittelständlern ist das sicherlich eine gute Nachricht.