Sehen

04.07.2024, 10:36 Uhr

04.07.2024, 10:36 Uhr

Kamera für Roboter funktioniert wie menschliches Auge

Ein Team unter der Leitung der University of Maryland (UMD) hat einen Kameramechanismus erfunden, der es Robotern ermöglicht, die Welt um sie herum genauer zu sehen. Die Entwickler liessen sich von der Funktionsweise des menschlichen Auges inspirieren.

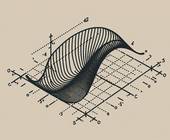

Der Mechanismus ahmt die winzigen unwillkürlichen Bewegungen nach, Mikrosakkaden genannt, mit denen das Auge bei Bedarf die Fokussierung auf ein Objekt über einen längeren Zeitraum sicherstellt.

Viel Bewegung als Problem

"Ereigniskameras können bewegte Objekte besser verfolgen als herkömmliche Kameras. Heutige Ereigniskameras haben jedoch Schwierigkeiten, scharfe, verwacklungsfreie Bilder aufzunehmen, wenn viel Bewegung im Spiel ist", sagt UMD-Doktorand Botao He. Ereigniskameras nehmen im Gegensatz zu herkömmlichen Kameras nicht ganze Bilder auf einmal auf, sondern registrieren für jedes lichtempfindliche Pixel getrennt nur die Veränderungen in der Helligkeit, also die "Ereignisse".

Die "Zapfen" und "Stäbchen" in der Netzhaut des menschlichen Auges, die für das Farbensehen beziehungsweise eine empfindliche Helligkeitsunterscheidung zuständig sind, senden nach Lichteinfall sofort elektrische Nervenimpulse aus. Diese werden dann in der Netzhaut teilweise zusammengeschaltet, vorverarbeitet und das entstehende Signal schliesslich ans Gehirn weitergeleitet. "Ähnlich funktionieren auch Ereigniskameras", sagt Guillermo Gallego von der Technischen Universität Berlin, der ebenfalls in dem Bereich forscht.

"Jedes einzelne lichtempfindliche Pixel trägt zeitlich unabhängig zum Gesamtbild bei. Es gibt keine Belichtungszeit, nach der alle Pixel auf einmal ausgelesen werden, wie bei normalen Kameras. Im Unterschied zum Auge lösen die Pixel aber nicht bei jedem Lichteinfall ein Signal aus, sondern nur, wenn sich die Helligkeit ändert. Das hat den Vorteil, dass die zu verarbeitenden Datenmengen vom Prinzip her wesentlich kleiner sind", konkretisiert Gallego.

Rotierendes Prisma ahmt nach

Dem Team um He ist es gelungen, Mikrosakkaden nachzubilden, indem es ein rotierendes Prisma einfügte, um die von der Linse eingefangenen Lichtstrahlen umzulenken. Die kontinuierliche Drehbewegung des Prismas simuliert die natürlichen Bewegungen des menschlichen Auges und ermöglicht es der Kamera, Objekte genauso zu fokussieren, wie ein Mensch es tun würde. Das Team entwickelte dann eine Software, um die Bewegung des Prismas zu kompensieren und stabile Bilder aus den wechselnden Helligkeiten zu erstellen.

"Bei Robotern oder selbstfahrenden Autos ersetzen Kameras die Augen und Computer das Gehirn. Bessere Kameras bedeuten bessere Wahrnehmung und Reaktionen", unterstreicht Yiannis Aloimonos, Informatiker an der UMD und Doktorvater von He. (pressetext.com)