Memory & Storage

11.03.2016, 09:52 Uhr

So speichern wir in Zukunft Daten

Phase-Change Memory, Nanodrähte und Kohlenstoff – die Speicherwelt verändert sich und dabei werden Memory- und Storage-Techniken zusammenwachsen.

Wenn Firmen die ihnen zur Verfügung stehenden Daten – und die werden immer mehr – sinnvoll nutzen wollen, dann brauchen sie dafür passende Analyse- und Storage-Lösungen. Die führenden Hersteller forschen bereits an Speichertechniken, die dem zu erwartenden Datenaufkommen gewachsen sind. Zum Teil befinden sie sich aber noch im Experimentierstadium und sind noch weit von einer Markteinführung entfernt.

Neue Anforderungen an Speicher

Klassische Speichertechniken sind angesichts des wachsenden Datenvolumens überfordert. Sowohl das Aufkommen an strukturierten Daten, etwa Kontotransaktionen oder Reisebuchungen, als auch an unstrukturierten Daten nimmt ständig zu, da unentwegt Videos, Musik und Bilder vor allem im Social Web gespeichert werden. Einen ungeheuren Datenschub wird zudem das Internet der Dinge auslösen, da Milliarden von Geräten, Sensoren und Kameras Daten austauschen werden.

Und genau hier liegt das Problem. Während strukturierte Daten sich mit herkömmlichen Speichertechniken in den Griff bekommen lassen, sind sie für die Flut an unstrukturierten

Daten viel zu langsam. Hierfür sind neue Anwendungen erforderlich, und diese Anwendungen benötigen für ihre Arbeit blitzschnellen Speicher.

Daten viel zu langsam. Hierfür sind neue Anwendungen erforderlich, und diese Anwendungen benötigen für ihre Arbeit blitzschnellen Speicher.

“„Eine der signifikantesten Hürden im modernen Computerdesign ist die Zeit, die vergeht, bis der Prozessor die Daten aus einem langfristigen Speicher erhält.“„

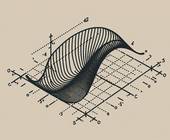

Bei der Entwicklung schneller Speichertechniken muss man berücksichtigen, wie Computer arbeiten (Stichwort Von-Neumann-Architektur): Alle Daten werden über einen Prozessor verarbeitet. Als (Zwischen-)Speicher verwendet ein Prozessor sogenannte Register. Je nach Taktfrequenz erreichen diese Register Zugriffszeiten im Nanosekundenbereich. Bei der Verarbeitung der Daten sind derzeit immer die Speichermedien der Flaschenhals, da deren Zugriffszeiten um ein Vielfaches langsamer sind als die der Register (siehe Grafik).

Unterschiede der Memory- und Storage-Techniken

Unternehmen, die mit Daten arbeiten, möchten diese nicht nur blitzschnell verarbeiten, sondern sie auch lange, kostengünstig und energieeffizient archivieren. Betrachtet man die Spanne zwischen dem schnellsten und teuersten Medium, dem CPU-Register, und dem günstigsten, aber auch langsamsten Medium, dem Magnetband (Tape), so lassen sich die Medien in Memory- und Storage-Techniken unterteilen.

Memory-Techniken sind überaus schnell, teuer und flüchtig – sie benötigen Strom, um den Speicher zu behalten. Storage-Techniken sind deutlich langsamer, dafür aber persistent – die Inhalte bleiben auch ohne Strom erhalten.

Performance-Lücke schliessen

Sieht man sich die aktuellen Speichertechniken an, so fällt auf, dass es zwischen DRAM (60 bis 70 ns) und Flash (100 µs) eine Lücke gibt, die mehr als den Faktor 1000 beträgt. Diese Lücke sollen Speichertechniken schliessen, deren Zugriffszeiten sich im Nanosekunden-Bereich bewegen, die nicht flüchtig sind und deren Kosten deutlich unterhalb von DRAM liegen. Gemeint sind Techniken, die die Unterschiede zwischen Memory und Storage überwinden – die also zugleich extrem schnell und kostengünstig sind. Die verschiedenen Ansätze, die es hier gibt, ordnet man der Kategorie Storage Class Memory (SCM) zu.

Einer dieser SCM-Ansätze ist Phase-Change Memory (PCM). Phase-Change Memory basiert auf Materialien (in der Regel sind es Chalkogenide), die zwischen einem amorphen Zustand mit hohem elektrischem Widerstand und einem kristallinen Zustand mit geringem Widerstand hin und her wechseln können. Solche Materialien werden seit etlichen Jahren in wiederbeschreibbaren Medien von optischen Laufwerken eingesetzt.

Phase-Change Memory und Racetrack-Speicher

Mit PCM können im Gegensatz zu NAND-Flash-Bausteinen einzelne Zellen beschrieben und gelesen werden. Die Zugriffszeiten liegen dabei im Nanosekunden-Bereich und die Zuverlässigkeit ist deutlich höher als bei Flash. Die Technik hat ein grosses Potenzial, der kommerzielle Durchbruch steht jedoch noch bevor. So konnte IBM zwar bereits im vergangenen Jahr PCM-Komponenten mit 2- und 3-Bit-Zellen demonstrieren, marktreif sind sie allerdings noch nicht.

Intel und Micron haben mit der 3D-XPoint-Technik angekündigt, den Speichermarkt verändern zu wollen. In der Branche wird spekuliert, dass die Technik auf PCM basiert. Daneben wollen auch HP und Sandisk bei der Entwicklung neuer Speichertechniken zusammenarbeiten. Konkrete Termine für Produkte gibt es in beiden Fällen noch nicht.

Racetrack-Speicher

Ausser an PCM-basierten Lösungen wird an weiteren Alternativen geforscht. Dazu zählt zum Beispiel die Racetrack-Speichertechnik.

Diese Technik fusst auf der Idee, dass Daten mit Hilfe gegensätzlich magnetisierter Bereiche auf ferromagnetischen Nanodrähten gespeichert werden und über Racetracks (Leseköpfe) sehr schnell (20 ns) auf den Nanodrähten verschoben werden können. Ausserdem können auf Racetrack-

basierten Speicherkomponenten etwa 100-mal mehr Daten als auf Flash-Bausteinen gespeichert werden – und das bei gleichem Platzbedarf.

basierten Speicherkomponenten etwa 100-mal mehr Daten als auf Flash-Bausteinen gespeichert werden – und das bei gleichem Platzbedarf.

Ein weiterer Ansatz basiert auf Kohlenstoff-Nanomaterialien, die sehr kleine und sehr stabile Strukturen ermöglichen. Daher werden die Kohlenstoff-Nanoröhrchen schon heute als künftige Ersatztechnologie für Transistoren gehandelt, sobald die Strukturen die 5-Nanometer-Grenze unterschreiten.

Starker Preisverfall bei Solid State Drives

Trotz aller Zukunftsmusik kommt auch die Weiterentwicklung aktueller Techniken nicht zu kurz. So vollzieht sich bei Flash-Komponenten gerade ein Wechsel von der 2D- zur 3D-Fertigung, bei der mehrere Schichten von Speicherzellen auf dem gleichen Wafer übereinandergelegt werden. Damit sind aktuell 32 bis 48 Schichten möglich und die maximale Anzahl wird weiter steigen. Sie erlauben höhere Kapazitäten bei geringeren Kosten, etwa 2,5-Zoll-SSD-Komponenten mit einer Speicherkapazität von mehr als 10 Terabyte. Mit Hilfe der 3D-Techik wird für Flash eine um den Faktor 10 erhöhte maximale Kapazität vorhergesagt.

Bei Festplatten gibt es hingegen keine Versuche, die mehr als eine Verdoppelung der Kapazität gängiger 3,5-Zoll-Festplatten ermöglichen. Aktuell liegen die grössten Kapazitäten bei 10 Terabyte. Das ist vor allem dem limitierten Platz geschuldet, der für die Lese- und Schreibköpfe bereitsteht. Daher wird sich die Speicherkapazität allerhöchstens noch um den Faktor 2 erhöhen. Diese und weitere Fakten sprechen eindeutig dafür, dass Flash-basierte Speichertechniken erfolgreich sein werden und die Bedeutung von magnetooptischen Festplatten nachlassen wird.

“„Storage Class Memory ist eine neue Mischform von Storage und Memory mit einzigartigen Eigenschaften.“„

Fazit

Memory- und Storage-Techniken werden zusammenwachsen. Hierbei werden sich vor allem Konzepte in den Vordergrund drängen, die neue Rohstoffe einsetzen, wie das bei den Kohlenstoff-Nanospeicherzellen der Fall sein wird. Aber auch bereits in Ansätzen entwickelte Technologien wie PCM können und werden die heutigen Speichertechniken ablösen und damit die Kluft zwischen den immer noch zu langsamen Flash-Speicherbausteinen und den superschnellen CPU-Registern verringern. Diese und andere Ansätze werden schon sehr bald die Grundlagen dafür schaffen, das datenintensive Analysieren unstrukturierter Daten massiv zu beschleunigen. Und das ganz ohne die aktuelle Flash-Technik.

Thomas Harrer, der Autor dieses Beitrags, ist CTO IBM Systems HW Sales DACH bei IBM Deutschland.