Datenanalysen schlagen das Bauchgefühl

Vorausschauende Wartung

Nicht fehlen darf bei den BI-Trends auch Predictive Analytics, die datengestützte Vorhersage bestimmter Ereignisse. Ein typisches Einsatzgebiet ist Predictive Maintenance, also die vorausschauende Wartung und Instandhaltung - ein Buzzword der digitalen Transformation. Die Deutsche Bahn etwa hat ihre Weichen in den vergangenen Jahren mit unzähligen Sensoren ausgestattet. Diese Sensoren messen den Strom, den der Motor benötigt, um eine Weiche zu stellen. Die Messwerte werden mit einer Soll-Kurve abgeglichen. Abweichungen lassen Rückschlüsse auf den Zustand der Weiche zu, und die Deutsche Bahn kann handeln, bevor die Weiche komplett ausfällt. Das spart Geld, vermeidet Zugausfälle und Verspätungen und erhöht somit gleichzeitig die Kundenzufriedenheit. Bis 2020 will die Bahn rund 30.000 Sensoren verbauen. Auch Windräder, Turbinen und Kraftfahrzeuge lassen sich mit Predictive Maintainance überwachen, indem Drehzahlen, Geräusche oder die Temperatur von Motoren erfasst und so Überhitzungen und Unwuchten frühzeitig erkannt werden. Aber es gibt auch kritische Stimmen, die Predictive Maintenance nur als Worthülse für Altbekanntes ansehen. Zudem lassen sich viele Ausfälle von Maschinen oder Bauteilen auf einen Faktor zurückführen, bei dem Predictive Maintenance wirkungslos ist, nämlich Bedienungsfehler.

Drohender Daten-GAU

Die eingangs beschriebene Datenexplosion gewinnt nicht zuletzt durch die Verbreitung des IoT an Rasanz. Schätzungen gehen von 50 Milliarden vernetzten IoT-Devices bis 2020 aus. Das wirft die Frage auf, wie sich die riesigen Datenmengen überhaupt noch sinnvoll speichern und analysieren lassen. IntraFind-Vorstand Franz Kögl sagt mit einem Augenzwinkern: «Ab und zu habe ich den Wunsch, vertrieblich bei einem Storage-Anbieter zu arbeiten.» Er ist der Ansicht, dass die Datenmengen mit den heutigen Technologien nicht mehr sinnvoll auszuwerten sind. Bei einem vernetzten Auto falle jede Stunde 1 Terabyte Messdaten an, mit denen nichts gemacht werde. «Die Daten sind da, aber sie können nicht ausgewertet werden.» Deshalb müsse man Analysesysteme einsetzen, um die Daten zu entschlacken und sich von Datenmüll zu befreien.

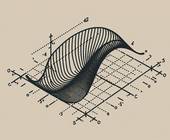

Mindbreeze-Geschäftsführer Daniel Fallmann ist anderer Ansicht: «Daten zu speichern, ist heute nicht mehr das grosse Problem, Speichermöglichkeiten sind ausreichend und zu günstigen Konditionen vorhanden.» Die Speicherdichte steige darüber hinaus nach wie vor rasch und die Geschwindigkeit der Speichermedien ebenfalls. «Beim Thema Daten- und Informationsanalyse wird es schon schwieriger, wenn man bedenkt, dass viele unterschiedliche Datenquellen in Unternehmen vorhanden sind und Daten sowohl strukturiert als auch unstrukturiert gespeichert werden.» Es gibt viele Konzepte der Datenspeicherung, etwa hierarchische Datenbanken, relationale Datenbanken, Cubes, In-Memory- und Spaltendatenbanken. Sie alle sind entstanden, um immer grössere und vielfältigere Datenmengen zu unterstützen.

Wer sich mit Big Data befasst, kommt schnell auf Hadoop zu sprechen, das freie Open-

Source-Framework auf Basis von Java und dem Map-Reduce-Algorithmus von Google. Die Aufgabe von Hadoop besteht darin, sehr grosse Datenmengen effizient in Clustern zu verarbeiten. Die Rechenleistung der einzelnen Knotenpunkte im Cluster wird dabei mitgenutzt. Hadoop lässt sich installieren oder über die Cloud betreiben. Ein grosser Pluspunkt liegt in der kostengünstigen Umsetzung. Dank Java läuft Hadoop zudem auf beinahe jeder Hardware.

Source-Framework auf Basis von Java und dem Map-Reduce-Algorithmus von Google. Die Aufgabe von Hadoop besteht darin, sehr grosse Datenmengen effizient in Clustern zu verarbeiten. Die Rechenleistung der einzelnen Knotenpunkte im Cluster wird dabei mitgenutzt. Hadoop lässt sich installieren oder über die Cloud betreiben. Ein grosser Pluspunkt liegt in der kostengünstigen Umsetzung. Dank Java läuft Hadoop zudem auf beinahe jeder Hardware.

Auch die an der UC Berkeley entwickelte Datenanalyse-Plattform Spark erfreut sich zunehmender Beliebtheit und wird inzwischen von vielen als ernsthafte Konkurrenz für Hadoop angesehen. Apache Spark legt im Gegensatz zu Hadoop den Fokus ganz auf die In-Memory-Datenverarbeitung. Die zu analysierenden Daten werden dabei direkt im Arbeitsspeicher der Cluster-Knoten gespeichert und verarbeitet. Dieses Verfahren bringt enorme Geschwindigkeitsvorteile gegenüber anderen Systemen, bei denen die Daten zunächst vom Festspeicher geladen werden müssen. Spark lagert die Daten nur dann auf die Festplatten aus, wenn die Datenmengen zu gross werden. Talend-Manager Jan Wetzke berichtet: «Viele Unternehmen setzen auf cloudbasierte Data Lakes. Dieser Ansatz ist kosteneffizient, skalierbar und flexibel in der Nutzung. Neue Architekturen wie Serverless und individuelle Abrechnungsmodelle helfen dabei, die beste Performance zu dem jeweils vorhandenen Budget zu erhalten.» Aber auch auf BI-Ebene gelte die Weisheit: Garbage in, Garbage out. Die Qualität der Daten entscheidet über die Qualität der Ergebnisse.

Daten lassen sich in drei Gruppen unterteilen: strukturiert, semistrukturiert und unstrukturiert. Unstrukturierte Daten enthalten Textdokumente und andere Arten von Dateien, die für einen Computer nicht leicht lesbare Formate aufweisen. Unstrukturierte Daten lassen sich nicht in Zeilen und Spalten darstellen, was für herkömmliche Data-Mining-Software eine Analyse erschwert. Der überwiegende Teil der von Unternehmen produzierten Daten - Schätzungen gehen von 85 Prozent aus - liegt aber in unstrukturierter Form vor. Bei der Suche nach einer geeigneten Business-Intelligence-Software sollte angesichts so vieler unstrukturierter Daten also die Qualität der Textanalyse eine zentrale Rolle spielen.