Datenanalyse

10.02.2018, 11:35 Uhr

Mit Analyse-Tools relevanten Daten auf der Spur

Analyse-Tools geben Hilfestellung, um Marktlücken zu entdecken und Trends aufzuspüren. Die Lösungen optimieren damit bestehende Prozesse und helfen beim Aufbau neuer Geschäftsmodelle.

Zugegeben, der Spruch „Daten sind das Erdöl unserer Zeit“ ist bereits etwas in die Jahre gekommen. Andererseits ist er aktueller denn je. Nach Angaben des Beratungshauses ISG Research wird 2018 und darüber hinaus die Nutzung von Daten für den Aufbau neuer Geschäftsmodelle massiv an Bedeutung gewinnen.

Derzeit stellt sich die Situation noch etwas anders dar: „Oft werden nur bestehende Geschäftsprozesse um Daten aus neuen Quellen angereichert und damit verfeinert“, erläutert Holm Landrock, Senior Supervisor bei ISG Research. „Ein Beispiel ist ein verhaltensabhängiger Versicherungstarif, bei dem neue Daten erschlossen werden, die letztlich aber nur das 100 Jahre alte Produkt ,Kfz-Schadensregulierung‘ modifizieren.“

Bereits heute nutzen viele Branchen Daten aller Art, um Prozesse zu optimieren oder mehr über ihre Kunden zu erfahren. Vorreiter sind Fertigungsunternehmen, die beispielsweise eine vorausschauende Wartung von Maschinen einsetzen, Finanzdienstleister und Versicherungen. Auch der Handel setzt verstärkt auf Big Data und Datenanalysen, etwa für die Auswertung von Social-Media-Informationen.

Auch Landwirte benötigen Daten

Nach Einschätzung von Landrock werden 2018 vor allem zwei Branchen verstärkt mit Data Analytics konfrontiert sein: das Gesundheitswesen und der Agrarsektor. „Auch die Landwirtschaftsbranche wird immer grössere Datenbestände gewissermassen analytisch durchpflügen“, so Landrock. Beispiele sind das Precision Farming mit Hilfe von GPS-gesteuerten Landmaschinen sowie die Verarbeitung von Sensordaten und Informationen, die von Drohnen stammen. Zudem lassen sich Kühe mit Chips ausstatten, etwa um deren Laufwege zu verfolgen und einen Zusammenhang mit den Milcherträgen zu ermitteln.

Markt wächst rasant

Von dem wachsenden Bedarf an verwertbaren Daten, auf deren Basis Unternehmen möglichst in Echtzeit Geschäftsentscheidungen treffen können, profitieren die Anbieter von Business-Intelligence- und Analytics-Lösungen. Das Marktforschungshaus Gartner beispielsweise geht davon aus, dass der weltweite Umsatz mit solchen Tools von rund 18 Milliarden Dollar im Jahr 2017 bis 2020 auf rund 23 Milliarden Dollar steigen wird. Das entspricht einem Plus von rund 19 Prozent pro Jahr.

Auf ähnliche Zahlen kommen die Marktforscher von MarketsandMarkets. Sie erwarten, dass Unternehmen 2021 an die 27 Milliarden Dollar für Business-Analytics-Software ausgeben werden.

Ein wichtiger Trend ist laut Gartner: „User und Geschäftsentscheider wollen die Option haben, dass sich solche Lösungen auch für einzelne Nutzer und Abteilungen bereitstellen lassen“, betont Rita L. Sallam, Research Vice President bei Gartner. Das bedeutet, dass flexiblere und kleinteiligere Ansätze gefragt sind, die schnell implementiert und an geänderte Anforderungen angepasst werden können.

Hier kommt die Cloud ins Spiel. BI oder Datenanalyse as a Service, die Nutzer von einem Cloud-Service-Provider beziehen, erfüllen diese Vorgaben. Die Dienste lassen sich ohne hohen Aufwand installieren. Datenbank-Server, Storage-Systeme und die Installation einer komplexen Software im eigenen Rechenzentrum sind nicht erforderlich. Zudem können weitere Lizenzen nach Bedarf geordert werden, etwa wenn weitere Mitarbeiter Zugang zu Analysen benötigen.

Kleinere Firmen setzen auf Cloud

Solche Faktoren sind offenkundig vor allem für kleinere und mittelständische Unternehmen verlockend. Das ergab eine Anwenderbefragung des Würzburger Beratungsunternehmens BARC. Demnach setzen 67 Prozent der kleineren Firmen BI-Werkzeuge aus der Cloud ein. Von den Grossunternehmen sind es nur 57 Prozent.

Bei Datenmanagement- und Analyse-Lösungen zeigt sich ein ähnliches Bild. Ein Grund dafür ist, dass Cloud-Lösungen einen geringeren Aufwand mit sich bringen. Nutzer müssen sie nicht im eigenen Rechenzentrum implementieren und betreiben, inklusive der erforderlichen Hardware. Ein potenzieller Nachteil ist die Abhängigkeit von schnellen Datenleitungen. Sind diese nicht vorhanden, können Performance-Probleme auftreten.

Obwohl der Betrieb von Geschäftsanwendungen in der Cloud allgemein sehr beliebt ist, scheinen es die Unternehmen bei der Implementierung von BI und Analytics in Cloud-Umgebungen dennoch nicht besonders eilig zu haben, so BARC. Dies gelte besonders für Firmen in Europa, während die Akzeptanz in Nord-, Mittel- und Südamerika und vor allem im Asien-Pazifik-Raum grösser sei.

„Es spricht sehr viel für Cloud-BI. Firmen können dadurch unter anderem flexibler auf Veränderungen reagieren und den Verwaltungsaufwand für ihre IT-Abteilungen vor Ort deutlich reduzieren“, sagt Carsten Bange, Gründer und Geschäftsführer des Beratungshauses BARC. „Aus unserer Beratungspraxis in Europa wissen wir, dass es nicht an der

Attraktivität der Plattformen selbst liegt, dass so viele Unternehmen noch zögern, ihre BI-Landschaften in die Cloud zu verlagern.“

Attraktivität der Plattformen selbst liegt, dass so viele Unternehmen noch zögern, ihre BI-Landschaften in die Cloud zu verlagern.“

Vielmehr herrschen noch Bedenken hinsichtlich rechtlicher Aspekte, Sicherheit und Datenschutz vor. Zudem verfügen etliche Unternehmen noch über zu wenig Fachwissen in puncto Implementierung und Betrieb von Cloud-BI-Lösungen. Weitere Gründe sind mangelndes Vertrauen in die Anbieter oder deren Stabilität sowie der Wunsch, die Unternehmensdaten nicht aus der Hand zu geben.

Vielzahl von Lösungsansätzen

Wer eine cloudgestützte BI- oder Analytics-Plattform nutzen möchte, steht zunächst vor folgendem Problem: Er muss aus der Fülle von Analyse- und Business-Intelligence-Produkten das passende Angebot herausfiltern. Erschwert wird dies dadurch, dass die Grenzen zwischen BI und reinen Analyse-Lösungen verschwimmen. Wurde BI bislang vor allem mit Reports und der Analyse von historischen Daten assoziiert, so hat sich das mittlerweile geändert. BI-Schwergewichte wie IBM, Microsoft, Oracle, SAS, Salesforce und SAP haben ihre BI-Angebote um Funktionen wie Predictive und Advanced Analytics erweitert.

Gleichzeitig sind auf dem Markt kleine, agile Anbieter aktiv. Zu ihnen gehören beispielsweise Clear Story Data, Domo und Birst. Ein Teil von ihnen konzentriert sich auf spezielle Bereiche wie das semantische Datenmanagement, Social Analytics – die Analyse von Social-Media-Daten –, die Aufbereitung und Integration von Daten oder maschinelles Lernen.

Speziell in Deutschland haben zudem zahlreiche Systemhäuser, Systemintegratoren und Beratungsunternehmen den Cloud-BI- und -Analytics-Markt für sich entdeckt. Die Studie „ISG Provider Lens Germany 2018 – Data Analytics Services & Solutions“ von ISG Research Deutschland listet beispielsweise in diesem Sektor Unternehmen wie Axians, Allgeier, Capgemini und Deloitte auf.

Hinzu kommen Analyse-Tools, die sich in vorhandene Business-Intelligence-Pakete einbinden lassen. Zu diesen zählt beispielsweise BI Office des niederländischen Unternehmens Pyramid Analytics. Die Software setzt auf Microsofts Business-Intelligence-Plattform Power BI auf. Die Fixierung auf Microsoft war allerdings auch einer der Hauptkritikpunkte an dem Analyse-Paket. Mittlerweile hat Pyramid mit Pyramid 2018 eine erweiterte Analytics-Software vorgestellt, die das Unternehmen als Analytics OS vermarktet. Sie basiert auf Java und arbeitet unabhängig von bestimmten Systemen und BI-Plattformen.

Die Grossen zieht’s in die Cloud …

Der Trend, BI-Umgebungen und Analytics-Anwendungen via Cloud bereitzustellen, wird sich nach Einschätzung der meisten Marktforscher in den kommenden Jahren massiv verstärken. Daher haben auch die grossen Anbieter solcher Lösungen ihre Angebotspalette entsprechend erweitert.

Oracle hat beispielsweise mit Analytics Cloud eine komplette BI-Suite in die Cloud portiert, inklusive Analyse-Funktionen, die Nutzer nach dem Selbstbedienungsprinzip verwenden können. Den Analysten von Gartner zufolge fühlen sich allerdings manche Interessenten von der Komplexität des Angebots überfordert. Preislich liegt Oracle trotz der Komplexität seiner Lösung dagegen mit etwa 75 Dollar durchaus im üblichen Rahmen.

“„Wir unterstützen Kunden dabei, ihr Unternehmen zu vereinfachen und an das digitale Zeitalter anzupassen.“ „

Eine vergleichbare Strategie wie Oracle verfolgen Microsoft mit Power BI und SAP. Der deutsche Software-Anbieter hat seine Analytics-Angebote in der SAP Analytics Cloud gebündelt. „Unser Analyseportfolio hilft Kunden, ihre Geschäftsabläufe besser nachzuvollziehen. Wir unterstützen sie auf diese Weise dabei, ihr Unternehmen zu vereinfachen und an das digitale Zeitalter anzupassen“, sagt Mike Flannagan, Senior Vice President SAP Analytics und SAP Leonardo bei SAP. Um die Datenanalyse-Funktionen zu erweitern, setzt SAP auf KI- und Machine-Learning-Ressourcen aus seinem Leonardo-Portfolio. Eine Version von SAP Analytics Cloud für bis zu 20 Nutzer ist für 21 Dollar pro Anwender und Monat erhältlich.

“„Es spricht sehr viel für Cloud BI. So können Firmen flexibler auf Veränderungen reagieren und den Verwaltungsaufwand reduzieren.“ „

Zu den etablierten Anbietern von modernen BI-/Analytics-Lösungen mit einem starken Cloud-Angebot zählen laut Gartner unter anderem auch IBM, Tableau, Qlik und SAS. Alle haben ihre Produktpalette um cloudbasierte Analyse-Lösungen erweitert beziehungsweise vorhandene Produkte entsprechend ergänzt.

Teilweise haben Nutzer mehrere Optionen: die Installation einer Lösung On-Premise, also im eigenen Rechenzentrum, oder die Nutzung eines Cloud-Angebots. Auch hier gibt es mehrere Möglichkeiten. SAS etwa bietet SAS Visual Analytics über eigene Cloud-Data-Center an. Ausserdem ist die Suite über Amazon Web Services verfügbar, den weltweit grössten Cloud-Service-Provider.

… die Kleinen sind schon da

Speziell der Analytics-Markt wird durch eine Vielzahl von Anbietern geprägt, die erst seit einigen Jahren aktiv sind. Zwei Beispiele sind Birst und Sisense. Das New Yorker Unternehmen Sisense legt Wert auf eine einfache Bedienung. Den Gartner-Analysten zufolge nutzen Anwender weniger die Analysefunktionen der Plattform, sondern eher Reports und Dashboards. Das Erstellen von Daten- und Abfragemodellen sowie die Aufbereitung von Daten war bislang weitgehend Spezialisten vorbehalten. Positiv ist, dass Nutzer zwischen einer Hybrid und einer Private Cloud wählen können. Auch ein Betrieb ohne Cloud ist möglich.

“„User und Geschäftsentscheider wollen die Option haben, dass sich BI- und Analytics-Lösungen auch für einzelne Nutzer und Abteilungen bereitstellen lassen.“ „

Birst wiederum hat stärker Smart-Data- und Analyse-Anwendungen im Fokus. Eine Besonderheit ist Networked BI, eine Virtualisierungsebene für Daten und darauf aufsetzende Analysen. Dadurch, so der Anbieter, bleibt die Konsistenz von Daten gesichert, auch wenn unterschiedliche Abteilungen und Mitarbeiter sie für Analysen heranziehen. Zudem greifen alle Nutzer stets auf denselben Datenbestand zu. Birst zählt zu den Anbietern von BI-/Analytics-Tools, die ausschliesslich auf eine Cloud-Architektur setzen.

Preis: ab etwa 25 Dollar

Die Einstiegspreise für die Cloud-Versionen von Analytics-Software bewegen sich meist zwischen 25 Dollar und 35 Dollar pro Anwender und Monat.

Tableau verlangt beispielsweise für die Personal Edition seiner Lösung Tableau Desktop rund 35 Dollar. Diese Version stellt grundlegende Funktionen bereit, etwa die Verknüpfung von Daten in Microsoft-Excel-Tabellen oder Spreadsheets von Google. Vielen Unternehmen dürfte das jedoch nicht genügen. Sie benötigen eine Anbindung an Datenbanken, etwa auf Basis von SQL. Ausserdem beschränken etliche Anbieter die Basisausgaben ihrer BI- und Analyseangebote auf eine bestimmte Zahl von Nutzern, zum Beispiel auf 20. Das ist für ein kleines Unternehmen akzeptabel, nicht aber für einen Mittelständler.

Wer mehr Funktionen benötigt oder eine BI-/Analytics-Plattform einer grösseren Zahl von Mitarbeitern zugänglich machen will, muss in der Regel zu Business- oder Enterprise-Versionen der Applikationen greifen. Dann steigen die Kosten pro Nutzer im Monat schnell auf rund 70 bis 100 Dollar oder noch mehr. In jedem Fall sollten Anwender prüfen, ob weitere Kosten hinzukommen, beispielsweise für Storage-Kapazitäten oder die Anbindung an Datenbanken.

Hilfreich: eine Hybrid-Option

Nur wenige Nutzer von Datenmanagement-, Analyse- und BI-Werkzeugen setzen komplett auf einen cloudgestützten Ansatz. Vielmehr zeichnet sich ab, dass speziell Unternehmen in Deutschland einen Mittelweg gehen: Ein Teil der Datenverarbeitung bleibt On-Premise, also im eigenen Rechenzentrum. Das gilt vor allem für unternehmenskritische Informationen und personenbezogene Daten. Weniger sensible Datenauswertungen werden dagegen as a Service bei Cloud-Service-Providern gebucht.

Daher ist es wichtig, dass die gewählten BI-/Analytics-Plattformen einen Hybrid-Ansatz unterstützen: Sie sollten sich in einer Private Cloud implementieren lassen, also im hauseigenen Data-Center. Gleichzeitig stellt der Anbieter im Idealfall eine Anbindung an eine zusätzliche Cloud-Komponente zur Verfügung.

“„Bei Analytics- und Cloud-Spezialisten gibt es derzeit ein heißes Eisen, nämlich dieVertiefung des maschinellen Lernens über Deep Learning.“ „

Ein Hybrid-Modell auf Grundlage derselben Plattform ist in jedem Fall einer Strategie vorzuziehen, bei der parallel unterschiedliche Produkte zum Zuge kommen: eines für die Bearbeitung von Daten On-Premise sowie eine Cloud-Version von einem anderen Hersteller. Das führt zwangsläufig zu erhöhten Kosten und bindet unnötig Ressourcen, etwa in der hauseigenen IT-Abteilung.

Datenkompetenz ist gefordert

Analyse-Tools, Big Data und BI-Werkzeuge aus der Cloud oder dem Rechenzentrum sind für alle Unternehmen unverzichtbar, die aus Daten nutzbringende Informationen gewinnen möchten.

Hinzu muss allerdings ein weiterer Faktor kommen, so Robert Schmitz, General Manager Central & Eastern Europe bei Qlik: „Datenkompetenz ist inzwischen ebenso bedeutend wie Lesen und Schreiben. Daten verleihen Argumenten Gewicht und helfen dabei, bessere Entscheidungen zu treffen.“ Das gewinne an Bedeutung, denn „im Alltag haben wir es mit einer stets wachsenden Datenfülle zu tun – und es wird immer notwendiger, kompetent damit umzugehen.“

“„Datenkompetenz ist inzwischen ebenso bedeutend wie Lesen und Schreiben.“ „

Doch gerade an dieser Datenkompetenz hapert es in vielen Unternehmen und bei vielen Mitarbeitern offenkundig. Das ergab eine Studie, die Qlik in Europa durchführen liess. Demnach gaben 85 Prozent der Beschäftigten in europäischen Unternehmen an, dass ihnen besseres Datenmaterial und ein umfassenderes Verständnis solcher Informationen bei ihrer Arbeit helfen würden. Doch nur 49 Prozent haben auch Zugang zu den dafür relevanten Datenbeständen. Ganze 24 Prozent gaben an, dass sie geschäftsrelevante Informationen optimal nutzen können. Besonders auffallend ist, dass viele Fachleute und Führungskräfte zwar immerhin Zugang zu Daten haben, die für Analysen relevant sind, sie verfügen aber nach eigener Einschätzung nicht über die notwendige Kompetenz, diese Daten auch sinnvoll zu nutzen.

Das heisst, BI- und Analyse-Tools allein reichen nicht aus. Sie sind nur Mittel zum Zweck. Damit Anwender diese Werkzeuge nutzbringend einsetzen können, benötigen sie Schulungen und die entsprechende Datenkompetenz.

Diese Problematik betrifft im Übrigen nicht nur Facharbeiter oder kleine Angestellte. Der Studie zufolge halten sich lediglich 10 Prozent der Absolventen von Hochschulen für datenkompetent. Abhilfe müssen deshalb nicht zuletzt auch die Ausbildungsstätten selbst schaffen, in Form von Lehrangeboten und Trainings.

Von KI bis zu Edge Analytics

Zu den Entwicklungen, die den Bereich Datenanalyse und Business Intelligence in den kommenden Jahren massgeblich prägen werden, zählt der Einsatz von maschinellem Lernen (ML) und Künstlicher Intelligenz (KI).

Nahezu alle Anbieter von BI- und Analytics-Software haben ihre Produkte um solche Funktionen ergänzt oder haben dies in absehbarere Zeit vor. Ein wichtiges Kriterium ist dabei, den Nutzern den Einstieg in Künstliche Intelligenz und Machine Learning so einfach wie möglich zu machen.

„Die SAP Leonardo Machine Learning Foundation bietet Kunden, Partnern und Entwicklern digitale Intelligenz – und zwar unabhängig davon, ob diese sich erstmals mit diesem Thema beschäftigen oder bereits über eigene Data-Science-Teams verfügen“, erklärt beispielsweise Markus Noga, Leiter des Bereichs Machine Learning bei SAP. Der deutsche Software-Konzern hat Ende 2017 seine Machine-Learning-Plattform um Services erweitert, die unter anderem mehrdimensionale Zeitreihenanalysen ermöglichen. Damit können Anwender unter anderem den optimalen Preis für ein Produkt ermitteln.

„Bei Analytics- und vor allem Cloud-Spezialisten gibt es derzeit ein heisses Eisen, nämlich die Vertiefung des maschinellen Lernens über Deep-Learning-Systeme beziehungsweise neuronale Netzwerke, die mittels Plattformen und Schnittstellen angesteuert und verknüpft werden können“, bestätigt auch Heiko Henkes, Manager Advisor bei ISG Research Deutschland.

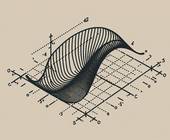

Deep Learning ist eine Technik, die es Systemen gewissermassen erlaubt, eigenständig zu lernen und dadurch Muster und Cluster in grossen Datenbeständen zu identifizieren. Techniken wie Deep Learning werden auch deshalb an Bedeutung gewinnen, weil durch das Internet der Dinge die Datenbestände sprunghaft anwachsen.

Je mehr Daten erfasst, aufbereitet und ausgewertet werden sollen, desto mehr Rechenleistung ist jedoch erforderlich. Um Engpässe in den Rechenzentren für die Cloud-Dienste zu vermeiden und die Datenleitungen zu entlasten, zeichnet sich im Bereich Analytics eine Dezentralisierung ab: Systeme am Rand eines Unternehmensnetzes führen eine erste Bearbeitung von Daten durch. Dies ist speziell in IoT-Umgebungen wichtig, in denen Daten in Echtzeit verarbeitet werden müssen. Dazu zählen zum Beispiel Produktionsumgebungen. So kann etwa ein Laufband bei Problemen nicht einfach stillstehen, bis die IoT-Sensoren Rückmeldung aus dem Rechenzentrum in der Cloud erhalten. Hier ist eine möglichst rasche Verarbeitung der Daten unerlässlich.

Für solche oder ähnliche kritische Einsatzzwecke stehen spezielle Analyse-Lösungen bereit. Führende Anbieter in diesem Bereich sind derzeit Microsoft mit Azure Stream, IBM mit Watson sowie Cisco Connected Steaming Analytics. Auch Intels Analytics Toolkit und Oracle mit Oracle Edge Analytics sind in diesem Marktsegment aktiv.

Solche Datenanalyse-Plattformen werden ebenfalls in der Regel als Cloud-Service angeboten. Damit haben auch kleinere Unternehmen die Chance, in diesem Umfeld mitzuspielen. Speziell für Deutschland mit seinen vielen Tausend kleineren Mittelständlern ist das sicherlich eine gute Nachricht.