PSI: Ein neuer Forschungsbereich zur Bewältigung grosser Datenmengen

Den Wandel begleiten

Das SCD sei der richtige Ort, um solche neuen Werkzeuge zu erproben. Dafür müssen Experimentatoren, Theoretikerinnen, Computerexperten, Ingenieurinnen und viele mehr miteinander reden. Das sei notwendig, damit Computerwissenschaftler die richtigen Lösungen für sie fänden, so Marie Yao. Sie wurde eigens am SCD eingestellt, um die Sprachverwirrung zu überwinden und die Veränderung zu begleiten für bestmögliche wissenschaftliche Resultate.

«Wandel ist nicht immer einfach», weiss Yao, die mehrere Jahre in einer ähnlichen Position in den USA gearbeitet hat. Manche Mitarbeitenden hätten Angst vor Bedeutungsverlust und würden an alten Abläufen festhalten. Sie sieht ihre Aufgabe darin, Teamarbeit zu fördern und ein Umfeld zu schaffen, in dem sich alle sicher und wertgeschätzt fühlen durch den von ihnen geleisteten Beitrag zu besseren technischen Lösungen.

Dazu koordiniert Yao im Team von Ashton an der Schnittstelle von SCD und den weiteren Divisionen am PSI die Entwicklungen für den Start der SLS 2.0 im Jahr 2025 und trägt dazu bei, technische Lösungen zu entwickeln. Bis dahin müssen Hardware, Software und Netze bereit sein und die enormen Datenmengen bewältigen. Ein ganzheitlicher Ansatz sei wichtig, so Yao: «Die ganze Datenpipeline ist nur so stark wie ihr schwächstes Glied.»

Ein zunehmendes Problem, in der Wissenschaft wie auch in anderen Bereichen der Wirtschaft, ist der Fachkräftemangel. Wenn es nicht genügend geeignete Experten gebe, müsse man sie ausbilden, häufig auf interdisziplinären Gebieten, so Yao.

Die Forschenden von morgen haben einiges an Arbeit vor sich. Software zur Lösung wissenschaftlicher Fragestellungen ist oft zwanzig Jahre alt und teilweise nicht effizient genug. Die Defizite mit noch mehr Rechenleistung zu erschlagen, funktioniert heute nicht mehr. Wissenschaftliche Software muss fit gemacht werden für die rasant wachsenden Datenmengen und für Trends im Höchstleistungsrechnen wie die Nutzung von Grafikprozessoren anstatt von herkömmlichen zentralen Rechen- und Steuereinheiten eines Computers. «Das SCD kann helfen, Leute anzuziehen, die genau so etwas können», glaubt Yao.

Maschine und Modellierung

Im Fall von Andreas Läuchli ist das gelungen. Er ist neben Adelmann und Nicola Marzari der Leiter des dritten wissenschaftlichen Labors am SCD, das sich mit theoretischer und computergestützter Physik beschäftigt. Vor einem Jahr kam er aus Innsbruck ans PSI und an die EPFL. Läuchli soll die Theorie stärken, aber Hand in Hand mit den Experimentalphysikern arbeiten und ihnen Ideen für neue Experimente geben, vor allem am SwissFEL sowie an der SLS 2.0. «Experimente und Theorie werden immer komplexer. Wer erfolgreich forschen und publizieren will, braucht dafür eine gute Maschine und eine gute Modellierung.» Das SCD sei Bestandteil dieser Synthese.

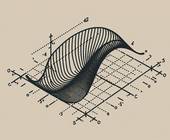

Läuchlis Steckenpferd sind Vielteilchensysteme, worunter in der Physik alles fällt, das mehr als ein einzelnes Wasserstoff-Atom ist – also nahezu sämtliche Materie auf der Erde. Alle Wege, Energieniveaus in diesen Systemen zu bestimmen, führen über die Schrödinger-Gleichung. Sie liefert für das Wasserstoff-Atom exakte Ergebnisse, für Vielteilchensysteme wächst der Rechenaufwand exponentiell. Deshalb weichen Forschende schon bei wenigen Atomen auf Näherungen aus. Doch nicht immer ist sicher, dass die Näherungen nah genug an der Realität sind.

Dann packt Läuchli die Brechstange aus. «Brute force» nennt sich die Methode, bei der er mit brachialer Rechenleistung die Schrödinger-Gleichung für bis zu fünfzig Teilchen in die Knie zwingt. 20'000 Prozessorkerne mit mehreren Terabytes Arbeitsspeicher rechnen dann simultan mitunter mehrere Wochen an so einem Problem. Selbst der Supercomputer in Lugano ist dann zeitweise für andere Nutzer gesperrt. Läuchli: «Manchmal ist die Brute-force-Methode wichtig, um zu überprüfen, ob unsere Näherungen wirklich gültig sind.»